automation-de.com

31

'22

Written on Modified on

Stemmer imaging News

DEEP LEARNING, SCHNELLE ENTWICKLUNGSUMGEBUNGEN UND FERTIGUNGSINTEGRATION

Künstliche Intelligenz in Form von Deep Learning ist eine der wichtigsten Entwicklungen der letzten Jahre in der industriellen Bildverarbeitung. Deep Learning setzt künstliche neuronale Netze ein, die die Arbeitsweise des menschlichen Gehirns bei der Erkennung und Entscheidungsfindung nachahmen.

Deep Learning eignet sich besonders gut für die Klassifizierung von Objekten sowie die Erkennung und Segmentierung von Defekten und wird in den unterschiedlichsten Branchen eingesetzt wie beispielsweise in der Automobilindustrie und Luft- und Raumfahrt, in der pharmazeutischen und Halbleiterindustrie sowie in Logistik, Transport und Verkehr.

Auch die Lebensmittelindustrie und Landwirtschaft können enorm von Deep-Learning-Methoden profitieren, da organische Produkte viele natürliche Variationen aufweisen, die man bei der Bewertung potenzieller Fehler und Klassifizierungsprobleme berücksichtigen muss. Deep Learning ist heute benutzerfreundlicher und praxisorientierter als je zuvor. Im Zusammenspiel mit anderen Bildverarbeitungstechnologien eröffnen sich eine Vielzahl neuer Anwendungsmöglichkeiten, besonders für optische Systeme im Umfeld von Industrie 4.0.

Deep-Learning-Funktionen

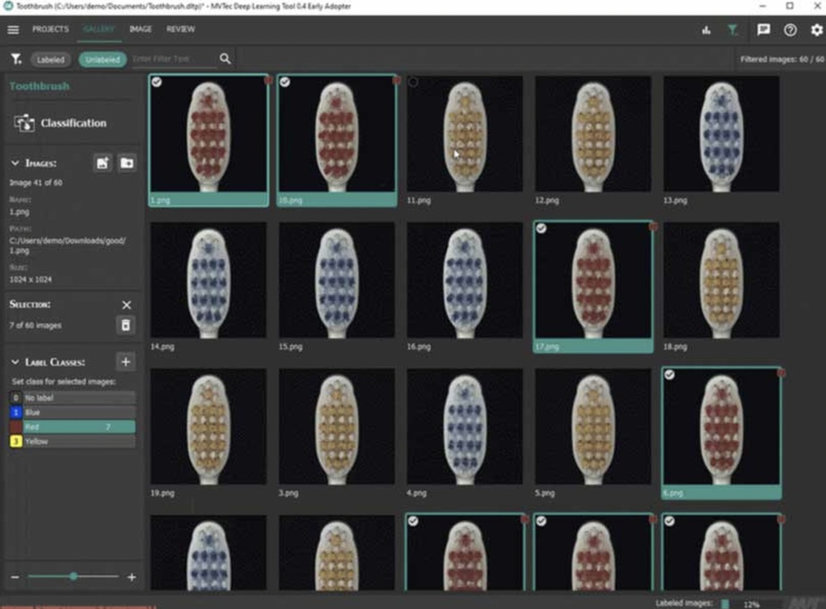

Bei der Entwicklung eines Deep-Learning-Systems wird ein neuronales Netz mit einer Reihe von Bildern trainiert, die verschiedene Objekte und/oder Defekte kennzeichnen, damit das System lernt, diese zu identifizieren. Das Bild zeigt eine Reihe von Bildern mit Zahnbürsten, die für das Training gelabelt wurden. Das trainierte System bewertet die Ausgabebilder der konkreten Anwendung. Die Ergebnisse können in ein Prozesskontrollsystem für die Qualitätssicherung eingebunden werden und liefern wertvolle Daten, um Fehlerursachen zu ermitteln, den Prozess zu optimieren und Ausschuss zu reduzieren.

Eine besondere Fähigkeit von Deep Learning ist die Klassifizierung, also die Einordnung von Objekten in eine bestimmte Kategorie. Einige Klassifikatoren liefern lediglich Ja/Nein-Entscheidungen, während andere Zuordnungen in entsprechende Kategorien vornehmen können.

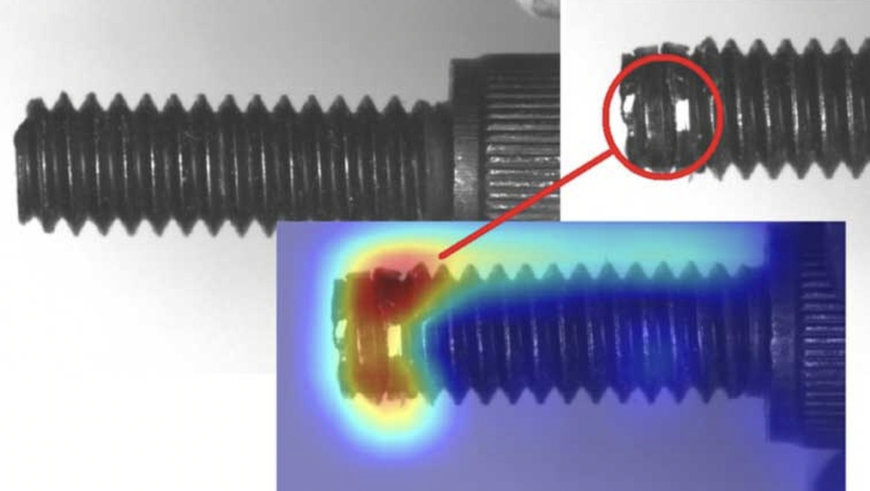

Anwendungsbeispiele sind Fehlererkennung, Zeichenerkennung, Anwesenheitserkennung, Lebensmittelsortierung usw. Das Beispielbild zeigt die Erkennung eines Defekts an einer Metallschraube mithilfe eines Klassifikators.

Eine neuere Funktion von Deep Learning ist es Anomalien zu erkennen. Hierbei kommt ein "Ja/Nein"-Klassifikator zum Einsatz, der den Vorteil hat, dass er nur "gute" Beispielbilder zum Trainieren benötigt. Treten Unterschiede in den Prüfbildern auf, kennzeichnet er diese als "schlechte" Beispiele.

Die Anomalieerkennung ist für jede Anwendung einsetzbar, bei der es um die Fehlererkennung auf einer Oberfläche oder eines Prüfszenarios geht. Ein neues Netz kann oft in nur wenigen Sekunden trainiert werden, da es nur eine kleine Anzahl von "guten" Bildern benötigt und keine Daten in diesen Bildern gelabelt werden müssen.

Zum Auffinden eines oder mehrerer Objekte in einem Bild können Objekterkennungsmethoden verwendet werden, die sowohl die Lokalisierung als auch die Klassifizierung in einem einzigen Arbeitsschritt kombinieren. Mit dieser Methode lassen sich Aufgaben wie Anwesenheitserkennung, Objektverfolgung, Fehlerlokalisierung und -sortierung usw. lösen.

Eine weitere wichtige Komponente des Deep Learning ist die Bildsegmentierung, die für die Klassifizierung/Qualifizierung von Defekten, die Sortierung von Lebensmitteln, die Analyse von Formen usw. verwendet wird. Das Verfahren vereinfacht die Analyse, indem es das Eingangsbild in segmentierte Gruppen von Pixeln unterteilt, die ganze Objekte oder Teile von Objekten darstellen, anstatt einzelne Pixel zu betrachten.

Zu den realen Anwendungen von Deep Learning gehört die Erkennung von Defekten selbst auf schwierigen Oberflächen wie z. B. Kratzer und Dellen auf gedrehten, gebürsteten oder glänzenden Teilen. Es lassen sich auch Defekte in gewebten Materialien, auf Arzneimittelpillen oder auf Halbleiterkontaktflächen erfolgreich identifizieren.

Deep Learning kann auch für anspruchsvolle OCR-Anwendungen eingesetzt werden (selbst bei verzerrtem Druck), z. B. zum Lesen von Kfz-Kennzeichen. Besonders geeignet ist die Technologie zur Erkennung und Klassifizierung von Merkmalen bei Obst, Gemüse und Pflanzen, sowohl für die Verarbeitung als auch für die automatische Ernte. In der Logistik hilft sie beispielsweise beim Auffinden leerer Lagerregale.

Einfache Implementierung von Deep Learning

Deep-Learning-Tools sind inzwischen in All-in-One-Softwareplattformen für die schnelle Entwicklung von Bilderfassungs- und Analyseprogrammen verfügbar. Dieser "Point-and-Click"-Ansatz spart Zeit und reduziert die Komplexität bei der Entwicklung von Deep-Learning-Lösungen, da keine speziellen Programmierkenntnisse mehr erforderlich sind Mit vortrainierten neuronalen Netzen lässt sich Deep Learning noch schneller in Anwendungen integrieren, da weniger Trainingsbilder und somit kürzere Trainingszeiten notwendig sind.

Deep Learning und 3D-Bildverarbeitung

Insbesondere bei kamerageführten Robotersystemen kommt zunehmend 3D-Bildverarbeitung zum Einsatz – und zwar immer häufiger in Kombination mit Deep Learning. Durch die direkte Verbindung zwischen Robotern und 3D-Kameras können deren Koordinatensysteme mittlerweile ohne Rechner als Zwischeninstanz abgeglichen werden.

Mehrere 3D-Kameras lassen sich zu einem gemeinsamen Koordinatensystem vernetzen und die Ergebnisse der einzelnen Sensoren zu einer einzigen 3D-Punktwolke kombinieren.

Auch die 3D-Inspektion größerer Objekte ist so möglich. Es sind sogar 3D-Laserlinienprofiler mit unterschiedlichen Auflösungen in einem Koordinatensystem kombinierbar. Verschiedene Bereiche eines Bauteils können so gleichzeitig inspiziert werden. Bewährte neuronale Standardnetzwerke werden mit 3D-Bildern trainiert, bevor man sie auf Live-Bilder angewendet. Objekte lassen sich so klassifizieren oder Defekte erkennen und segmentieren.

Das Bild oben zeigt die 3D-Klassifizierung von Schweinerücken, die sich auf einem Hochgeschwindigkeitsförderband bewegen. Nach der Erfassung der 3D-Profile klassifiziert das KI-Modell linke oder rechte Teilstücke, basierend auf Höhe, Mindestfläche, Abstand zwischen den Teilen und maximaler Länge. Die Sortierentscheidung wird an nachgelagerte Maschinen weitergegeben.

Die Deep-Learning-Technologie findet sich auch zunehmend in der Robotik wider. Beispielsweise kann ein neuronales Netz mit 3D-Daten aus einem Szenario verwendet werden, um die Teile und ihre Oberflächen zu bewerten und so optimale Teile von der Robotik entnommen werden.

Deep Learning ist äußerst rechenintensiv, und neuronale Netze lassen sich in der Cloud oder auf CPUs oder GPUs am Rand des Netzwerks (so nah wie möglich an der Bildquelle) ausführen.

Die Netze können zwar entweder „on the edge“ oder in der Cloud eingerichtet, trainiert und optimiert werden, aber die Verwendung von Live-Bildern ist höchstwahrscheinlich zeitkritisch und wird daher am besten in der Netzwerkperipherie durchgeführt.

Dies reduziert nicht nur die erforderliche Reaktionszeit und Bandbreite, sondern ist auch leicht skalierbar, verringert die Latenzzeit für Anwendungen, die eine schnelle Reaktion erfordern, und erhöht die Sicherheit durch Minimierung der Datenübertragung.

Inzwischen sind kompakte, robuste, industrietaugliche CPU/GPU-Kombinationen mit erheblicher Rechenleistung verfügbar, um ultraschnelles GPU-beschleunigtes Edge-AI-Computing zu ermöglichen.

Die Daten können in definierten Zeitabständen an entfernte Datenzentren oder in die Cloud übertragen werden, um sie langfristig zu speichern oder über mehrere Netzwerke zu verteilen. Dieser Prozess eignet sich auch dazu Anpassungen am Deep-Learning-Modell vorzunehmen.

Während viele Bildverarbeitungssysteme für die Fabrikautomation über eine direkte Schnittstelle zu Bussystemen wie Ethernet IP, Profibus und Modbus verfügen, erfordert der Umstieg auf Industrie 4.0 eine bessere Konnektivität, um die Datenübertragung und den Datenaustausch zwischen allen Komponenten innerhalb der Fabrikstruktur zu ermöglichen.

Der plattformunabhängige, offene Standard OPC UA für die Maschine-zu-Maschine-Kommunikation stellt für den Datenaustausch aller Komponenten ein gemeinsames Kommunikationsprotokoll bereit.

Der VDMA (Verband Deutscher Maschinen- und Anlagenbau e.V.) hat die OPC UA Companion Specification Vision (OPC Machine Vision) entwickelt, die über Bildverarbeitungssoftware und komplette, schlüsselfertige Bildverarbeitungssysteme verfügbar ist. Damit steht ein generisches Informationsmodell für alle Bildverarbeitungssysteme zur Verfügung, von einfachen Bildverarbeitungssensoren bis hin zu komplexen Prüfsystemen.

OPC Machine Vision ergänzt oder ersetzt nicht nur bestehende Schnittstellen zwischen einem Bildverarbeitungssystem und seiner weiteren Prozessumgebung durch den OPC UA Standard, sondern ermöglicht auch neue horizontale und vertikale Integrationspfade für die relevante Datenkommunikation zu anderen Teilen des Prozesses bis hin zur IT-Infrastruktur im Unternehmen.

Mithilfe von OPC Machine Vision kann das Bildverarbeitungssystem mit der Fertigungsanlage und darüber hinaus zu kommunizieren. Beispielsweise lassen sich auf diese Weise Aufträge für Bildverarbeitungssysteme aus ERP-Systemen laden und Batch-Ergebnisse und Statistiken an das ERP-System zurückgeben.

Die Grafik zeigt die Einführung von OPC Machine Vision, wobei die blauen Linien die konventionellen Kommunikationswege und die orangefarbenen Linien die Kommunikation mit OPC-UA darstellen.

www.stemmer-imaging.com

Fordern Sie weitere Informationen an…